APMIC 推出的「CaiGunn 開講」在地化大型語言模型,結合 HPE ProLiant DL320 Gen11 和 DL380a Gen11 伺服器,提供高效生成式 AI 應用,助企業加速 AI 專案部署。 透過強大的硬體支持,該模型在智能客服和知識管理上顯著提升效率,解決應答率低和內部文件管理問題,強化企業競爭力。

生成式 AI 持續帶動產業革命,無論是內容生成、智慧客服、程式轉寫等領域均展現出絕佳的回應能力,成企業轉型及強化競爭力的關鍵武器,企業無不將導入生成式 AI 視為最重要的下一步布局。然而,在人才不足、預算有限的狀況下,企業若單憑一己之力推動生成式 AI 相關專案,恐將陷入推動時程長、成效難以預估等困境,故導入市面上的成熟 AI 模型被認為是最佳解方。

不過,生成式 AI 市場百家爭鳴,如雨後春筍般出世的 AI 公司及解決方案令人目不暇給,彷彿「亂紀元」般讓企業無所適從。而 APMIC(亞太智能機器)指出,企業要導入生成式 AI 模型強化競爭力時,可從兩大關鍵面向下手,如讓內部更多人能夠參與並投入 AI 專案的開發;以及所選 AI 解決方案是否涵蓋完善的系統整合,減少需要做出更多選擇和評估的時間。

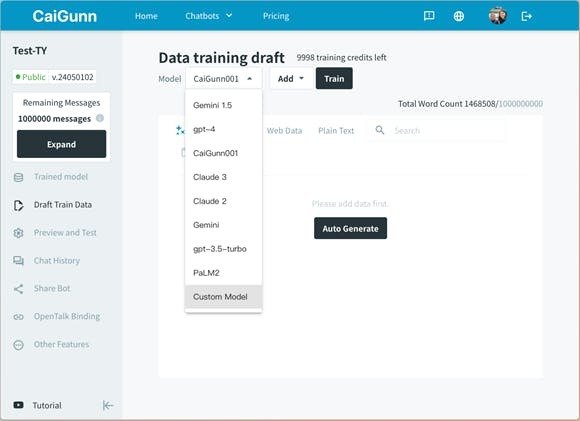

「CaiGunn 開講」是由 APMIC 打造的在地化大型語言模型,企業人員只要將現有的文章、網站或是文件資料上傳,不須撰寫任何程式,就能打造出最聰明且接地氣的聊天機器人。此大語言模型更支援各種資料格式的訓練,包含文字檔案、表格和網站爬蟲等,並且能夠根據特定任務進行微調,以提高在特定領域的表現。

在節省人力、加速專案時程等前提下, APMIC 獨家推出資料整理自動化機制,藉由系統之間 API 串接、資料去識別化、資料自動貼標與轉換等步驟,可快速利用資料進行訓練與調校的速度。「CaiGunn 開講」內建核心引擎判斷意圖機制,可節省客服系統的 20% 回覆時間,加上產品內建的提示範例達 100 多組,助每個員工都一鍵套用、輕鬆能成為善用 AI 工具的工程師「詠唱師」。

APMIC「CaiGunn 開講」整合專為 AI 應用所設計的 HPE ProLiant DL320 Gen11 / DL380a Gen11 伺服器,藉由內建加速器的 Intel Xeon Scalable 系列處理器與 NVIDIA GPU 晶片之間搭配,能協助企業將 AI 模型於公司內部快速落地,可實現絕佳的 AI 效能,以及最優異的應用程式可攜性。 Intel Xeon Scalable 系列處理器內建加速器,可實現更優異的核心效能和無與倫比的 AI 效能,以及最優異的應用程式可攜性。

近年來, HPE 在 AI 領域也投入大量資源,推動多項創新和應用。其中, HPE ProLiant DL320 Gen11 / DL380a Gen11 伺服器即為是專應對生成式 AI 應用的需求而生,主打可以免去開發和部署生成式 AI 基礎架構的複雜性,助企業加速完成「對話式搜尋」、「業務流程自動化」和「內容創作」等生成式 AI 模型的部署。 HPE ProLiant DL320 Gen11 伺服器是專為邊緣 AI 應用設計,最多可安裝四張 NVIDIA L4 GPU 卡,同時內建 NVIDIA Metropolis 工具;而 HPE ProLiant DL380a Gen11 伺服器則是為生成式視覺 AI、自然語言 AI 模型等應用設計,最多可安裝四張 NVIDIA H100 GPU 卡,同時亦提供 NVIDIA AI Enterprise 軟體套件。

APMIC 認為,讓 AI 模型透過系統整合真正落地的方案是這個時代所需,將與 HPE 一起持續協助客戶更加便利且深入地使用 AI 。他們也深信,讓企業內部更多人能夠參與 AI 的世界,不需要任何程式編寫或數據處理知識也能輕鬆使用,更是企業迎戰 AI 時代的關鍵思維。

因應不同企業運用場景,目前 APMIC「CaiGunn 開講」大型語言模型有 Mini、Pro、Ultra 等三種 AI 模型供選擇 ,應用場景涵蓋「GenAI 智能客服」,協助大幅解決應答率過低、或者回覆的內容與事實不符的問題,有效降低風險並強化企業形象;以及「GenAI 知識管理」,透過上傳並整理四散各處且格式不一的公司文件,員工只要透過問答形式,即可獲得想要的資訊,解決內部工作效率問題。在 APMIC 技術團隊的全方位顧問服務協助下,結合 HPE ProLiant DL320 Gen11 /DL380a Gen11 伺服器 的強大 AI 算力,企業不光可縮短推動 AI 專案執行速度,也能降低整體成本支出,強化在市場上的競爭力。

本文章內容由「APMIC & HPE & Intel」提供。